OpenAI præsenterer udfordrende robotmiljøer til forskning i kunstig intelligens

OpenAI har udgivet en teknisk rapport, der introducerer en række komplekse kontrolopgaver designet til at fremme forskningen inden for såkaldt Multi-Goal Reinforcement Learning – en gren af maskinlæring, hvor robotter lærer at løse opgaver gennem prøve-og-fejl-metoden.

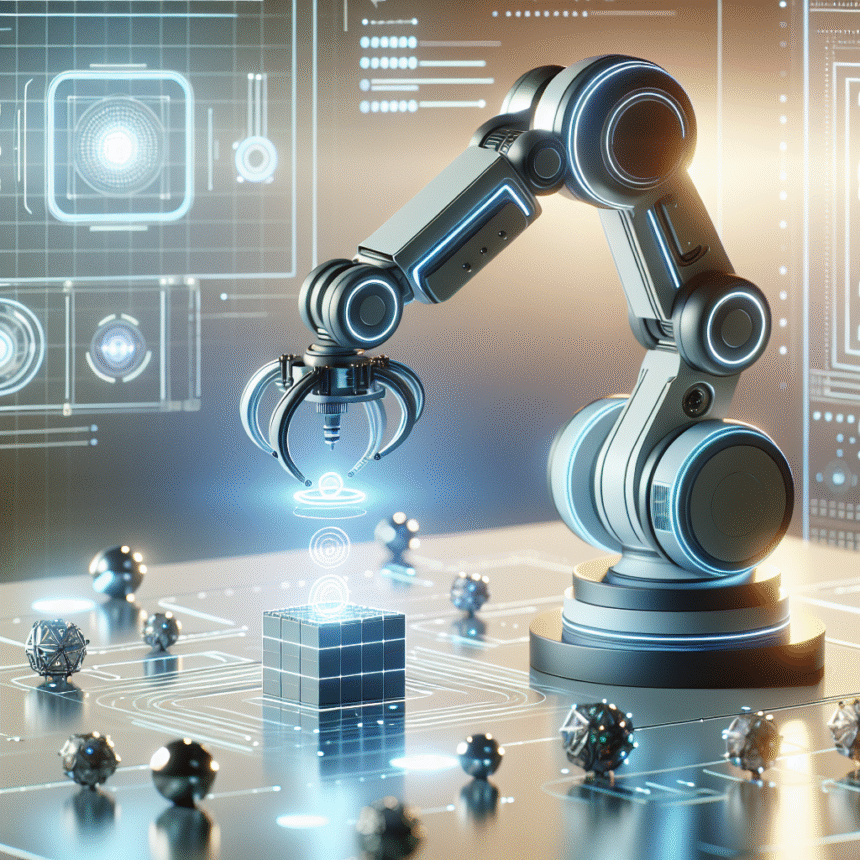

De nye testmiljøer er integreret med OpenAI Gym og baseret på eksisterende robothardware. Opgaverne omfatter en række avancerede manipulationsopgaver, herunder skubning, glidning og “pick and place”-operationer udført af en Fetch robotarm, samt kompleks objektmanipulation i hånden ved hjælp af en Shadow Dexterous Hand – en robothand med fingre.

Udfordrende betingelser for AI-systemer

Det særlige ved disse opgaver er, at de alle har såkaldte sparse binære belønninger, hvilket betyder, at robotten kun får feedback, når den fuldfører opgaven – ikke undervejs. Dette gør læringen betydeligt sværere end traditionelle metoder, hvor systemet får løbende feedback.

Opgaverne følger en Multi-Goal RL-ramme, hvor agenten får besked på, hvad den skal gøre gennem et ekstra input. Dette gør det muligt for samme system at lære at løse mange forskellige opgaver.

Opfordring til forskningssamarbejde

Ud over at præsentere de nye testmiljøer fremlægger rapporten også en række konkrete forskningsidéer til forbedring af reinforcement learning-algoritmer. De fleste af disse idéer er relateret til Multi-Goal RL og en teknik kaldet Hindsight Experience Replay.

Med udgivelsen opfordrer OpenAI forskere verden over til at arbejde med disse udfordrende miljøer for at accelerere udviklingen af mere avancerede robotsystemer.

Rapporten er forfattet af et team af forskere fra OpenAI, heriblandt Matthias Plappert, Marcin Andrychowicz og Wojciech Zaremba.