OpenAI frigiver robotmiljøer og algoritme til at lære af fejl

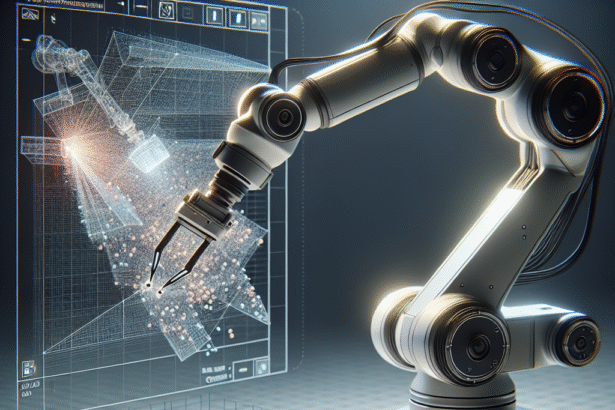

OpenAI har offentliggjort otte simulerede robotmiljøer samt en implementering af algoritmen Hindsight Experience Replay (HER), som forskere har udviklet gennem det seneste år. Værktøjerne, der er gjort tilgængelige via OpenAI’s Gym-platform, er designet til at træne modeller, som kan fungere på fysiske robotter.

De nye miljøer omfatter fire scenarier med Fetch-forskningsplatformen og fire med ShadowHand-robotten. Opgaverne spænder fra simple bevægelser til kompleks manipulation af objekter som klodser, æg og penne.

Læring gennem fejl

Det centrale i udgivelsen er HER-algoritmen, som introducerer et nyt paradigme inden for robotlæring. I stedet for kun at lære af vellykkede forsøg, kan algoritmen også udnytte fejlslagne forsøg konstruktivt.

Princippet er inspireret af menneskelig læring: Selvom man ikke rammer det oprindelige mål, har man stadig opnået et resultat. HER fungerer ved i eftertid at lade robotten “forestille sig”, at det opnåede resultat faktisk var målet hele tiden. På den måde kan systemet lære af hver eneste interaktion, uanset om den var succesfuld eller ej.

“Selv om vi ikke har ramt det ønskede mål, har vi i det mindste opnået et andet,” forklarer OpenAI i deres tekniske rapport. “Så hvorfor ikke bare lade som om, vi ville opnå netop dette mål fra starten?”

Sparse belønninger fungerer bedre

Overraskende viser OpenAI’s resultater, at algoritmen faktisk præsterer bedre med “sparse” belønninger – altså systemer hvor robotten kun får feedback ved succes eller fiasko – sammenlignet med traditionelle “tætte” belønninger, hvor systemet løbende får feedback.

I tests med den komplekse opgave HandManipulateBlockRotateXYZ, hvor ShadowHand-robotten skal manipulere en klods til en bestemt position og rotation, overgik DDPG+HER med sparse belønninger alle andre konfigurationer markant.

Forskningsopfordringer

Sammen med udgivelsen præsenterer OpenAI en række forslag til videre forskning, herunder:

- Automatisk udvælgelse af alternative mål i stedet for hårdkodede strategier

- Kombination af HER med hierarkisk reinforcement learning

- Hurtigere informationsspredning i træningsprocessen

- Integration med nyere algoritmer som Prioritized Experience Replay

De nye robotmiljøer og HER-implementeringen er tilgængelige som open source via OpenAI’s GitHub-repositorier og kan bruges med eksisterende Gym-kompatible reinforcement learning-algoritmer.