AI-agenter udvikler komplekse strategier gennem skjul-og-søg-spil

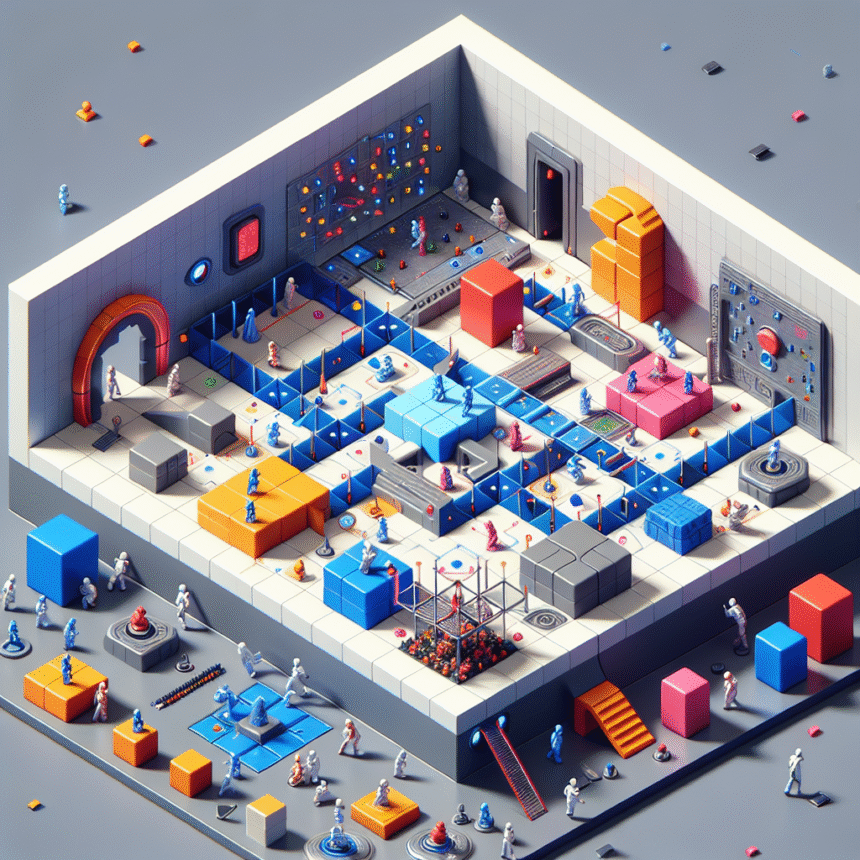

OpenAI har demonstreret, hvordan kunstig intelligens kan udvikle overraskende sofistikerede strategier gennem simpel konkurrence. I et virtuelt skjul-og-søg-miljø har AI-agenter selvstændigt lært at bruge redskaber og udvikle modstrategier på måder, som forskerne ikke havde forudset.

I eksperimentet blev AI-agenter opdelt i to hold: blå “gemmer-sig”-agenter og røde “søger”-agenter. Gemmer-sig-holdet skulle undgå at blive set, mens søger-holdet skulle holde øje med modstanderne. Agenterne kunne bevæge sig, se objekter i deres synsfelt, registrere afstande til omgivelser og andre agenter, samt gribe og låse objekter fast.

Det bemærkelsesværdige er, at agenterne ikke fik nogen direkte instruktioner om at interagere med objekterne i miljøet. Alligevel udviklede de gennem millioner af spilrunder seks forskellige strategier og modstrategier.

Fra tilfældighed til avanceret værktøjsbrug

Udviklingen startede simpelt: Først bevægede agenterne sig tilfældigt, derefter lærte søgerne at jagte gemmerne. Men omkring 22 millioner episoder begyndte gemmerne at konstruere ly ved at flytte kasser og blokere døre.

Som modtræk lærte søgerne efter 88 millioner episoder at bruge ramper til at hoppe over forhindringer. Dette tvang gemmerne til at udvikle en ny strategi: at låse ramperne fast for at forhindre søgerne i at bruge dem.

Den mest overraskende adfærd kom efter 388 millioner episoder, hvor søgerne opdagede “box surfing” – en teknik hvor de bragte en kasse til en låst rampe, hoppede op på kassen og “surfede” den hen til gemmernes skjulested. Dette var muligt på grund af agenternes evne til at påføre sig selv kraft, uanset om de stod på jorden eller ej.

Som det endelige modtræk lærte gemmerne at låse både ramper og kasser for at forhindre box surfing – en strategi der krævede koordination mellem holdmedlemmer.

Større skala gav bedre resultater

OpenAI brugte samme træningsinfrastruktur som til deres tidligere projekter OpenAI Five og Dactyl. Forskerne fandt, at storskaleret træning var afgørende for, at agenterne kunne nå gennem de forskellige udviklingsstadier.

Ved at øge batch-størrelsen kunne de drastisk reducere den tid, det tog agenterne at nå frem til avancerede strategier, selvom det ikke påvirkede antallet af nødvendige træningsepisoder væsentligt.

Utilsigtede opdagelser

Projektet afslørede også flere uventede måder, hvorpå agenterne udnyttede fysik-simulatoren. Udover box surfing fandt forskerne eksempler på, at gemmer-agenter i sjældne tilfælde lærte at løbe uendeligt langt væk med en kasse, og at søger-agenter kunne lancere sig selv op ad vægge ved at løbe mod dem i den rigtige vinkel med en rampe.

OpenAI sammenlignede deres tilgang med såkaldt “intrinsic motivation”-metoder, hvor agenter tilskyndes til at udforske gennem forskellige målinger. De fandt, at multi-agent konkurrence førte til langt mere menneskelignende og meningsfuld adfærd end de alternative metoder.

Forskerne mener, at multi-agent konkurrence vil være en mere skalerbar metode til at generere menneske-relevante færdigheder på en usuperviseret måde, efterhånden som miljøerne fortsætter med at vokse i størrelse og kompleksitet.