OpenAI præsenterer nyt miljø til måling af AI-agenters generaliseringsevne

OpenAI har frigivet CoinRun, et nyt træningsmiljø designet til at måle, hvor godt kunstig intelligens kan overføre sin erfaring til nye situationer. Udviklingen adresserer et grundlæggende problem inden for reinforcement learning (forstærkningslæring): AI-agenter har svært ved at generalisere deres læring til nye miljøer.

Overfitting er et centralt problem

Selvom moderne AI-agenter kan løse komplekse opgaver, kæmper de med at anvende deres erfaring i nye sammenhænge. Problemet er, at agenterne “overfitter” – de lærer specifikke detaljer om deres træningsmiljø i stedet for generaliserbare færdigheder. Paradoksalt nok bliver AI-agenter typisk evalueret på de samme miljøer, som de trænes på – en praksis, der ville være utænkelig inden for supervised learning.

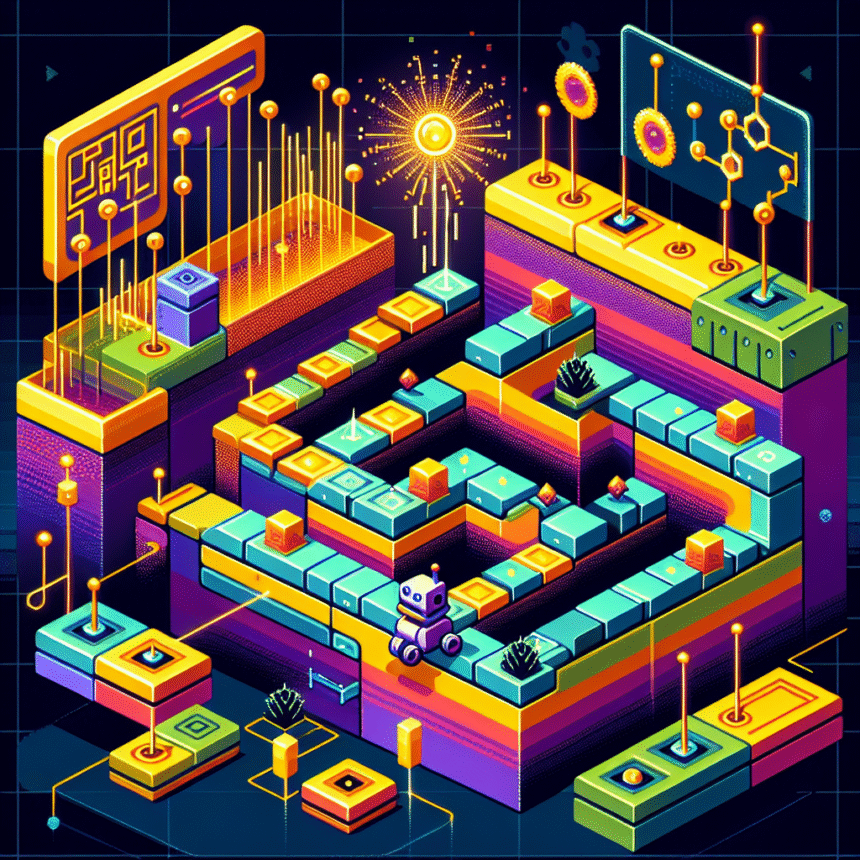

Sådan fungerer CoinRun

CoinRun er inspireret af platformspil som Sonic the Hedgehog. Målet i hvert level er simpelt: Saml den enkelte mønt, der ligger i slutningen af banen. Flere forhindringer, både stationære og bevægelige, står mellem agenten og mønten. Levels genereres proceduralt, hvilket giver adgang til et stort og målbart træningsdatasæt.

Overraskende resultater

OpenAI trænede 9 forskellige agenter med varierende antal træningslevels – fra 100 til 16.000 levels. Resultaterne var slående:

- Betydelig overfitting opstod ved mindre end 4.000 træningslevels

- Selv med 16.000 træningslevels var der stadig tegn på overfitting

- Agenter trænet på ubegrænsede levels (cirka 2 millioner forskellige) præsterede bedst

Arkitektur gør en forskel

Forskerne sammenlignede forskellige neurale netværksarkitekturer og fandt, at IMPALA-CNN-agenter generaliserede markant bedre end den almindeligt anvendte Nature-CNN-arkitektur på tværs af alle træningssæt.

Teknikker til bedre generalisering

Ved brug af et fast træningssæt på 500 levels testede OpenAI forskellige regulariseringsteknikker:

- L2-regularisering reducerede generaliseringsgabet betydeligt

- Data augmentation og batch normalization forbedrede generalisering markant

- Miljømæssig stokasticitet viste den største effekt

Fremtidige perspektiver

OpenAI opfordrer forskere til at bruge CoinRun som benchmark og foreslår flere forskningsretninger, herunder undersøgelse af forholdet mellem miljøkompleksitet og antallet af nødvendige træningslevels.

Resultaterne giver vigtig indsigt i udfordringerne ved generalisering i reinforcement learning og tilbyder et præcist værktøj til at måle overfitting – et afgørende skridt mod mere generaliserbare AI-systemer.