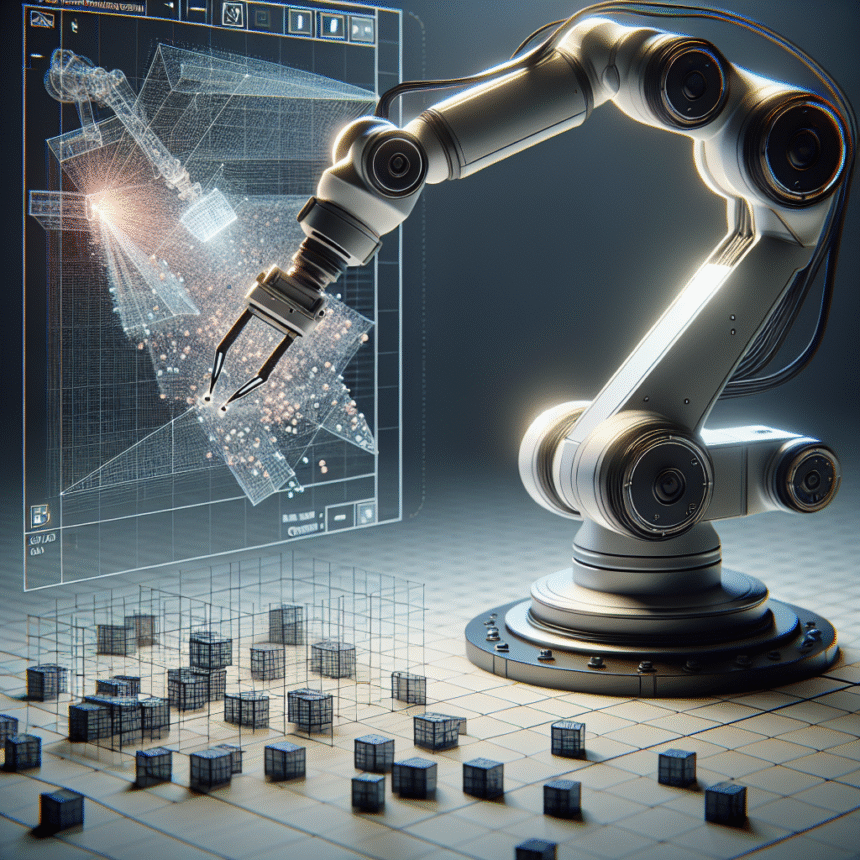

OpenAI præsenterer ny metode til at træne robotter med billedgenkendelse

OpenAI har offentliggjort en ny forskningsmetode, der gør det betydeligt lettere at træne robotter til at udføre komplekse opgaver ved hjælp af kamerabilleder. Metoden, kaldet “Asymmetric Actor Critic”, udnytter simulerede miljøer på en ny måde og kan overføre læring fra virtuelle verdener til virkelige robotter uden behov for træning på fysiske systemer.

Udnytter simulatorens fulde potentiale

Den nye tilgang adskiller sig ved at bruge forskellige typer information under træningen. Mens robotten (actor) kun får adgang til RGBD-kamerabilleder – ligesom den ville have i den virkelige verden – får den kritiske evalueringskomponent (critic) adgang til komplet information om alle objekters position og tilstand i simulatoren.

Dette asymmetriske setup giver robotten mulighed for at lære mere effektivt, da evalueringssystemet kan give bedre feedback baseret på fuld viden om miljøet, mens selve robotten trænes i at handle ud fra begrænsede visuelle input.

Fra simulation til virkelighed uden fysisk træning

Forskerne har kombineret metoden med såkaldt “domain randomization”, hvor simulationsmiljøet varieres under træningen. Dette gør robotten mere robust over for forskelle mellem den simulerede og den virkelige verden.

Resultaterne er lovende: OpenAI har demonstreret, at robotter trænet udelukkende i simulation kan udføre opgaver som at samle op, skubbe og flytte objekter i den fysiske verden – alt sammen uden nogen form for træning på rigtige robotter.

Betydning for robotteknologi

Metoden adresserer en af de største udfordringer inden for robotlæring: at træning på fysiske systemer er både dyrt, tidskrævende og potentielt farligt. Ved at gøre simulationsbaseret træning mere effektiv, kan udviklingen af intelligente robotter accelereres betydeligt.

Forskningen er udført af et team bestående af Lerrel Pinto, Marcin Andrychowicz, Peter Welinder, Wojciech Zaremba og Pieter Abbeel, og resultaterne er publiceret i en videnskabelig artikel.