OpenAI kombinerer sprogmodeller med evolutionær programmering i nyt forskningsgennembrud

OpenAI har offentliggjort en ny forskningsartikel, der demonstrerer, hvordan store sprogmodeller kan revolutionere genetisk programmering gennem en metode kaldet “Evolution through Large Models” (ELM).

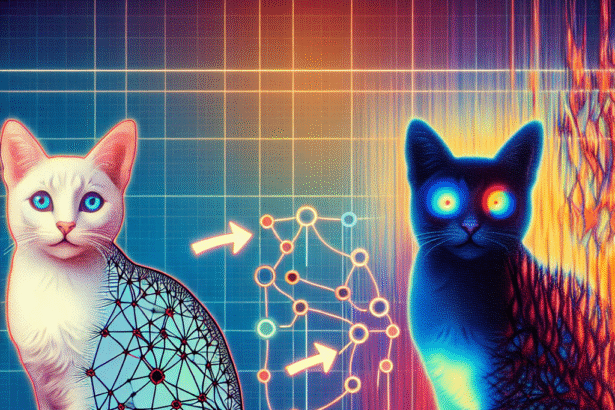

Forskerne bag studiet har opdaget, at store sprogmodeller, der er trænet til at generere kode, kan forbedre effektiviteten af mutationsoperatorer anvendt på programmer i genetisk programmering markant. Nøgleindsigten er, at disse modeller kan tilnærme de ændringer, som mennesker sandsynligvis ville foretage, fordi de er trænet på data, der inkluderer sekventielle ændringer og modifikationer.

Hundredtusindvis af funktionelle programmer genereret

I hovedeksperimentet kombinerede forskerne ELM med MAP-Elites-algoritmen og genererede hundredtusindvis af funktionelle Python-programmer. Disse programmer kunne producere fungerende, ambulerende robotter i Sodarace-domænet – et område som den oprindelige sprogmodel aldrig havde set under sin forudgående træning.

De genererede eksempler blev efterfølgende brugt til at træne en ny betinget sprogmodel, der kan producere den rette “walker” til et specifikt terræn.

Implikationer for AI-forskning

Ifølge forskerne bag studiet – Joel Lehman, Jonathan Gordon, Shawn Jain, Kamal Ndousse, Cathy Yeh og Kenneth O. Stanley – har metoden vidtrækkende konsekvenser for flere områder inden for kunstig intelligens:

- Open-endedness: Evnen til at skabe nye løsninger uden forudgående træningsdata

- Deep learning: Muligheden for at bootstrappe nye modeller fra kunstigt genererede data

- Reinforcement learning: Potentiale for at generere træningsdata i nye domæner

Forskningsartiklen understreger især betydningen af, at man nu kan træne modeller til at producere passende artefakter for en given kontekst i domæner, hvor der tidligere ikke var nogen træningsdata tilgængelig.

Studiet, der blev offentliggjort den 17. juni 2022, er tilgængeligt på arXiv og repræsenterer et nyt forskningsområde, hvor evolutionære algoritmer og store sprogmodeller kombineres på innovative måder.